Cuando contratamos un servicio de hosting generalmente viene con recursos limitados o algunos trucos que para vendernos un servicio “ilimitado” que al final si nuestro sitio se vuelve productivo o recibe cierta cantidad de visitas hace que lo suspendan o nos obliguen a contratar otro paquete por “exceso de visitas” e ir en contra de sus “políticas de uso justo” pero bueno de eso hablaremos en otra ocasión, en este punto nos dedicaremos a bloquear bots que utilizan recursos y que al parecer no nos brindan algún beneficio, si bien aquí pondremos una lista de 25 bots/spiders y cómo bloquear los 2 que más ancho de banda nos consumen, no necesariamente debes hacerlo.

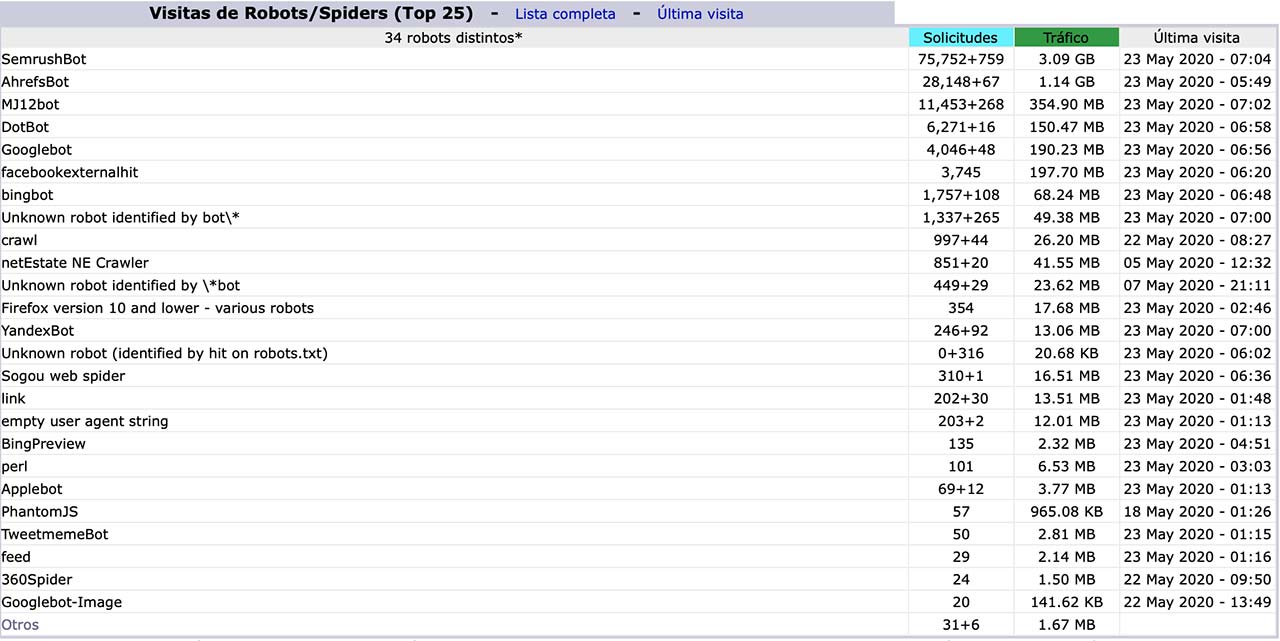

Empecemos con una lista que encontramos en un sitio propio:

Podemos ver la cantidad de solicitudes tráfico utilizado en el periodo, en este caso 23 días de mayo del 2020, algunos no dan mucho problema pero bots como SemrushBot lleva gastando cerca de 5gb de transferencia mensualmente y fuera de espiar lo que publicamos y venderlo a un tercero no le veo algún beneficio así que empezaremos bloqueando, recuerden no bloquear todos y menos el de Google si queremos que nuestro sitio este indexado correctamente.

[toc]

¿Cómo bloquear SemrushBot?

Primero veamos que hace antes de bloquearlo:

SEMrushBot es el software de búsqueda de bot que SEMrush envía para descubrir y recopilar datos web nuevos y actualizados.

Los datos recopilados por SEMrushBot se utilizan para:

- El índice del motor de búsqueda de backlink público mantenido como una herramienta dedicada llamada Backlink Analytics (gráfico web de enlaces)

- Site Audit, que analiza los problemas de SEO, técnicos y de usabilidad en la página

- Backlink Audit, que ayuda a descubrir y limpiar backlinks potencialmente peligrosos de su perfil

- Link Building, que lo ayuda a encontrar clientes potenciales, comunicarse con ellos y monitorear sus backlinks recién adquiridos

- SEO Writing Assistant para verificar si la URL es accesible

- la herramienta de monitoreo de marca para indexar y buscar artículos

- los informes de Content Analyzer y Post Tracking tools

- Informes de herramientas de la página de SEO Checker y SEO Content Template

- la herramienta de investigación de temas

Pero en el caso de este sitio corporativo no nos sirve de algo que alguien vigile nuestros contenidos para decirle a sus clientes además de que si su consumo fuera respetable no estaríamos hablando de quitarlo.

Ahora les mostraremos dos formas de hacerlo:

Bloquear SemrushBot utilizando robots.txt

Esta sería la opción común y recomendada, crear un archivo robots.txt y seguir las instrucciones qu

e ellos mismos comparten, sin embargo este proceso puede tardar hasta 2 semanas sin contar que si en algún momento no puede accesar.

#Bloqueando SEMrushBot

User-agent: SemrushBot

Disallow: /

User-agent: SemrushBot-SA

Disallow: /

User-agent: SemrushBot-BA

Disallow: /

User-agent: SemrushBot-SI

Disallow: /

User-agent: SemrushBot-SWA

Disallow: /

User-agent: SemrushBot-CT

Disallow: /

User-agent: SemrushBot-BM

Disallow: /

Con esto quedará bloqueado de la manera sugerida por el mismo robot siempre y cuando esperemos que haga caso, en caso de que queramos hacerlo de una manera más agresiva podemos negar el acceso utilizando .htaccess.

Bloquear SemrushBot utilizando .htaccess

Un paso más agresivo que nos ayudará a negar el acceso (aunque este bot es un poco tramposo y puede seguir trabajando haciéndose pasar por el bot de google)

Options +FollowSymlinks

RewriteEngine On

RewriteBase /

SetEnvIfNoCase User-Agent "^SemrushBot" bad_user

Deny from env=bad_user¿Cómo bloquear AhrefsBot?

Otro bot/spider comercial es AhrefsBot y es utilizado para vender información a empresas para tomar en cuenta al momento de hacer su compra de medios, pero si tu sitio no se comercializa de esa manera no veo necesario que ellos utilicen tu información y tu ancho de banda, puedes obtener más información de este robot en https://ahrefs.com/es/robot.

Bloquear AhrefsBot con robots.txt

Basta agregar lo siguiente a nuestro robots.txt y tardará un poco en dejar de consumirnos ancho de banda.

User-agent: AhrefsBot

Disallow: /Otros Bots/Spiders

MJ12Bot

Recolecta enlaces para el servicio comercial de majestic.com, podemos bloquearlo agregando lo siguiente a robots.txt

User-agent: MJ12bot

Disallow: /DotBot

Es el bot utilizado por el servicio de moz.com utilizado para SEO se puede bloquear utilizando lo siguiente en robots.txt

User-agent: dotbot

Disallow: /Siempre es bueno revisar las estadísticas en el caso de cPanel activar awstats ya que registra el gasto de ancho de banda de acuerdo a la ip de referencia y podemos darnos cuenta en donde estamos gastando recursos o detectar posibles ataques de determinadas IPs.